L’utilisation de l’intelligence artificielle (IA) s’est considérablement accrue ces dernières années et continue de se généraliser, à tous secteurs et tous types d’activités. Les entités, publiques et privées, intègrent de plus en plus ces technologies notamment pour optimiser leurs opérations, innover dans leurs offres de produits et services et renforcer leur compétitivité.

Ces usages ne sont pas sans risques et soulèvent des questions juridiques, notamment au regard des droits fondamentaux (non-discrimination, respect de la vie privée…), de la protection des données à caractère personnel, des droits de propriété intellectuelle, etc.

Quelles sont les réponses apportées par le règlement européen sur l’IA ? Quelles sont ses principales dispositions ? Et comment les entités concernées doivent préparer leur mise en conformité ? Tour d’horizon en sept questions !

1. Pourquoi un règlement européen sur l’IA ?

Le Règlement européen sur l’intelligence artificielle (AI Act), en créant un cadre juridique harmonisé (au sein de l’UE), vise à promouvoir le développement d’une IA « digne de confiance » et l’innovation en matière d’IA dans l’Union européenne, tout en respectant les droits et valeurs fondamentaux de celle-ci (« y compris la démocratie, l’état de droit et la protection de l’environnement […] » (Considérant 1, Règlement sur l’IA).

Le Règlement sur l’IA fait partie d’un ensemble plus large de mesures politiques, qui comprend également le train de mesures sur l’innovation dans le domaine de l’IA pour soutenir les PME et start-up et le plan coordonné sur l’IA pour soutenir les investissements en matière d’IA.

Trois ans après la proposition, par la Commission européenne en avril 2021, d’un Règlement sur l’IA – et à la suite d’intenses négociations – le texte a été formellement adopté le 13 juin 2024 et publié le 12 juillet 2024. Son calendrier d’application est précisé ci-après (voir question 6).

Source : Parlement européen

2. Que recouvre la notion d’éthique, mise en avant par ce règlement ?

Il est intéressant de noter que l’AI Act met l’accent sur la notion d’éthique, qui est expressément mentionnée dans ce texte. Que recouvre cette notion ?

Dès 2018, la Commission européenne a exprimé sa volonté de garantir « un cadre éthique et juridique approprié en matière d’IA » (tel qu’exprimé, par la suite, dans un Livre Blanc sur l’IA, paru en 2020). La Commission européenne a réuni un groupe d’experts de haut niveau sur l’intelligence artificielle (dit « GEHN IA »), groupe indépendant chargé d’élaborer des contributions, telles que des recommandations en matière de politique et d’investissement dans le domaine de l’IA et des « lignes directrices pour une intelligence artificielle digne de confiance ».

Le Conseil européen et le Parlement européen ont également affirmé leur volonté que les considérations éthiques soient pleinement intégrées dans le développement de l’IA et des technologies connexes, notamment dans une Résolution du Parlement du 20 octobre 2020 (Résolution contenant des recommandations à la Commission concernant un cadre pour les aspects éthiques de l’intelligence artificielle, de la robotique et des technologies connexes).

Les lignes directrices établies par le groupe d’experts (GEHN IA) « cherchent à ériger l’éthique en pilier essentiel de la mise au point d’une approche unique de l’IA cherchant à favoriser, renforcer et protéger tant la prospérité individuelle des êtres humains que le bien commun de la société. » Elles énoncent sept principes éthiques suivants : « action humaine et contrôle humain ; robustesse technique et sécurité ; respect de la vie privée et gouvernance des données ; transparence ; diversité, non-discrimination et équité. » Ces principes éthiques sont repris et définis dans le Règlement européen sur l’IA (Considérant (27), qui précise également que : « Ces principes devraient se retrouver, autant que possible, dans la conception et l’utilisation des modèles d’IA. Ils devraient en tout état de cause servir de base à l’élaboration de codes de conduite au titre du présent règlement. Toutes les parties prenantes, y compris l’industrie, le monde universitaire, la société civile et les organismes de normalisation, sont encouragées à tenir compte, ainsi qu’il convient, des principes éthiques pour l’élaboration de bonnes pratiques et de normes volontaires. »

3. Quel est le champ d’application du Règlement sur l’IA ?

Le législateur européen a choisi que ce champ soit le plus large possible, pour couvrir toutes les utilisations d’IA et afin d’atteindre les objectifs du Règlement.

- Tous secteurs d’activité

A l’exception des utilisations d’IA « exclusivement à des fins militaires, de défense ou de sécurité nationale » (article 2, Champ d’application)

- Toute la chaîne d’approvisionnement, tous les acteurs

Regroupés sous le terme d’ « opérateurs » : fournisseur, fabricant de produits, déployeur, mandataire, importateur ou distributeur (article 3, Définitions)

Le Règlement sur l’IA vise à fournir des règles claires et uniformes concernant la mise sur le marché, la mise en service et l’utilisation de systèmes d’IA dans l’UE (article 2, Règlement sur l’IA).

Un système d’IA est défini comme « un système automatisé qui est conçu pour fonctionner à différents niveaux d’autonomie et peut faire preuve d’une capacité d’adaptation après son déploiement, et qui, pour des objectifs explicites ou implicites, déduit, à partir des entrées qu’il reçoit, la manière de générer des sorties telles que des prédictions, du contenu, des recommandations ou des décisions qui peuvent influencer les environnements physiques ou virtuels ». (Article 3, Définitions)

4. Qu’est-ce que l’approche par les risques ?

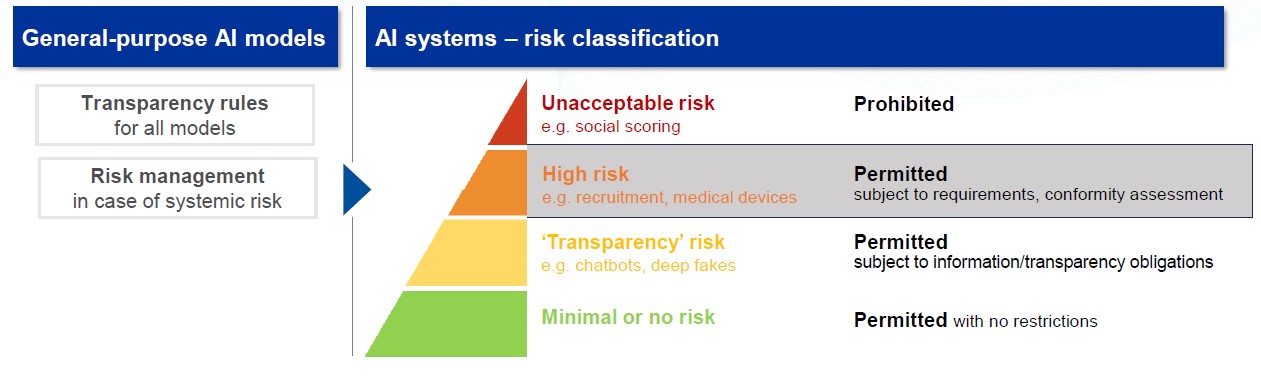

Le Règlement repose sur une approche de l’IA fondée sur les risques et introduit une distinction entre les systèmes d’IA selon les risques qu’ils représentent pour « la santé, la sécurité ou les droits fondamentaux des personnes » : risque inacceptable, élevé et faible ou minimal.

Selon les risques qu’ils induisent, les systèmes d’IA sont soit totalement interdits, soit autorisés et soumis à des obligations.

Source : European Artificial Intelligence Office

Pratiques interdites en matière d’IA

En vertu de l’article 5 du Règlement sur l’IA, sont des pratiques interdites « la mise sur le marché, la mise en service ou l’utilisation d’un système d’IA » :

- « Qui a recours à des techniques subliminales, ou à des techniques délibérément manipulatrices ou trompeuses, qui a pour objectif ou effet d’altérer substantiellement le comportement d’une personne ou d’un groupe de personnes en portant considérablement atteinte à leur capacité à prendre une décision éclairée […] » ;

- « Qui exploite les éventuelles vulnérabilités dues à l’âge, au handicap ou à la situation sociale ou économique spécifique d’une personne physique ou d’un groupe de personnes donné avec pour objectif ou effet d’altérer substantiellement le comportement de cette personne ou d’un membre de ce groupe d’une manière qui cause ou est raisonnablement susceptible de causer un préjudice important à cette personne ou à un tiers » ;

- « Pour mener des évaluations des risques des personnes physiques visant à évaluer ou à prédire le risque qu’une personne physique commette une infraction pénale, uniquement sur la base du profilage d’une personne physique ou de l’évaluation de ses traits de personnalité ou caractéristiques […] » ;

- Qui crée ou développe « des bases de données de reconnaissance faciale par le moissonnage non ciblé d’images faciales provenant de l’internet ou de la vidéosurveillance ; etc.

Est également une pratique interdite « l’utilisation de systèmes d’identification biométrique à distance en temps réel dans des espaces accessibles au public », sauf dans les cas expressément prévus à l’article 5.

Il est à souligner que ces interdictions entrent en application à compter du 2 février 2025.

Systèmes d’IA à haut risque

Sont, par exemple, identifiés comme à haut risque (cf. article 6 et Annexe III) les systèmes d’IA utilisés :

- Dans les infrastructures critiques (par exemple les transports, la fourniture d’eau, de gaz, de chauffage ou d’électricité), susceptibles de mettre en danger la vie et la santé des utilisateurs

- Pour l’emploi, la gestion des travailleurs et l’accès au travail indépendant (par exemple, un logiciel de tri de CV pour les procédures de recrutement) ;

- Pour évaluer la solvabilité des personnes physiques ou pour établir leur note de crédit, à l’exception des systèmes d’IA utilisés à des fins de détection de fraudes financières ;

- Pour l’évaluation des risques et la tarification en ce qui concerne les personnes physiques en matière d’assurance-vie et d’assurance maladie ;

- En matière de migration, asile et contrôle aux frontières (par exemple, pour l’examen des demandes d’asile, de visas et de titres de séjour) ;

- etc.

Le Règlement sur l’IA fixe des obligations spécifiques applicables aux systèmes d’IA à haut risque.

Pour pouvoir être mis sur le marché, ces derniers devront notamment répondre aux exigences suivantes :

- Systèmes adéquats d’évaluation et d’atténuation des risques ;

- Haute qualité des ensembles de données alimentant le système afin de minimiser les risques et les résultats discriminatoires ;

- Enregistrement des activités afin d’assurer la traçabilité des résultats ;

- Documentation détaillée fournissant toutes les informations nécessaires sur le système et son objet pour permettre aux autorités d’évaluer sa conformité ;

- Haut niveau de robustesse, de sécurité et d’exactitude ;

- etc.

Les entités vont devoir s’adapter, en amont, mais aussi tout au long de leurs processus internes, et mettre en place une série de mécanismes pour rester en conformité.

Systèmes d’IA à risque limité

Les systèmes d’IA à risque limité sont soumis à des obligations spécifiques en matière de transparence, notamment :

- Informer les utilisateurs lors de l’utilisation de systèmes d’IA comme les chatbots pour qu’ils puissent prendre des décisions éclairées ;

- Assurer l’identification du contenu généré par l’IA par les fournisseurs :

- Étiqueter les textes générés par l’IA, publiés dans un but d’information du public sur des questions d’intérêt public, comme étant générés artificiellement.

Systèmes d’IA à risque minimal ou nul

La grande majorité des systèmes d’IA actuellement utilisés dans l’UE relèvent de cette catégorie (applications de jeux utilisant des systèmes d’IA, filtres anti-spam…).

5. Quelles sont les sanctions prévues ?

Elles sont prévues à l’article 99 du Règlement sur l’IA.

- Concernant les pratiques interdites en matière d’IA (article 5) : Les amendes administratives peuvent atteindre jusqu’à 35 millions d’euros ou, si l’auteur de l’infraction est une entreprise, jusqu’à 7 % de son chiffre d’affaires annuel mondial total réalisé au cours de l’exercice précédent, le montant le plus élevé étant retenu. (Article 99)

- La non-conformité aux dispositions du Règlement, autres que celles énoncées à l’article 5, peut donner lieu à une amende administrative pouvant aller jusqu’à 15 000 000 EUR ou, si l’auteur de l’infraction est une entreprise, jusqu’à 3 % de son chiffre d’affaires annuel mondial total réalisé au cours de l’exercice précédent, le montant le plus élevé étant retenu. (Article 99)

- La fourniture d’informations inexactes, incomplètes ou trompeuses aux organismes notifiés

Ou aux autorités nationales compétentes en réponse à une demande fait l’objet d’une amende administrative pouvant aller jusqu’à 7 500 000 EUR ou, si l’auteur de l’infraction est une entreprise, jusqu’à 1 % de son chiffre d’affaires annuel mondial total réalisé au cours de l’exercice précédent, le montant le plus élevé étant retenu. Dans le cas des PME et start-up, pour les sanctions prévues à l’article 99, sera le montant le plus faible qui sera retenu.

6. Quel est le calendrier de mise en œuvre du règlement sur l’IA ?

Le Règlement sur l’IA sera pleinement applicable à partir du 2 août 2026 (article 113 du Règlement), à l’exception de certaines dispositions qui s’appliqueront avant, en particulier :

- l’interdiction des pratiques interdites s’applique à partir du 2 février 2025 ;

- les exigences relatives à l’IA à usage général : 2 août 2025 ;

- les obligations pour les systèmes d’IA à haut risque : août 2026.

Le Bureau européen de l’IA (European AI Office), créé en février 2024 au sein de la Commission européenne, supervise l’application et la mise en œuvre du Règlement sur l’IA avec les États membres. Le Bureau de l’IA est également chargé d’élaborer des lignes directrices afin d’aider les entités à préparer leur mise en conformité.

Ont déjà été publiées en février 2025 des lignes directrices portant sur la définition des systèmes d’IA et sur les pratiques d’IA interdites (depuis le 2 février 2025), visant à aider les acteurs concernés à mettre en œuvre le Règlement sur l’IA.

7. Quels sont les liens entre le Règlement européen sur l’IA et la Convention-cadre sur l’IA adoptée par le Conseil de l’Europe ?

Le 17 mai 2024, le Conseil de l’Europe (qui compte 46 pays membres) a adopté le premier Traité international sur l’intelligence artificielle : la convention-cadre sur l’IA et les droits de l’homme, la démocratie et l’État de droit.

La convention-cadre a été ouverte à la signature le 5 septembre 2024 à l’occasion d’une conférence à Vilnius, en Lituanie. Ses dispositions doivent être transposées en droit national, dans chacun des États signataires. Les parties doivent mettre en place un mécanisme de contrôle indépendant pour contrôler le respect de la convention.

Cette convention-cadre vise à garantir une IA respectueuse des droits fondamentaux : non-discrimination, respect des processus démocratiques, respect de la vie privée, etc.

Les dispositions de ce traité sont compatibles avec le Règlement européen sur l’IA. Cette convention-cadre constitue ainsi un texte juridiquement contraignant pour les États concernés : les 46 membres du Conseil de l’Europe, ainsi que 11 États non-membres (Argentine, Australie, Canada, Costa Rica, États-Unis d’Amérique, Israël, Japon, Mexique, Pérou, Saint-Siège et Uruguay) ayant participé à sa rédaction.

Pour aller plus loin

Voir les articles du blog sur l’adoption des bonnes pratiques et la mise en conformité en matière d’IA :

L’intelligence artificielle dans les contrats : enjeux et bonnes pratiques

Focus sur l’intelligence artificielle dans le secteur financier : quels usages, quel cadre ?

Qu’est-ce que le dispositif d’alerte mis en place dans le cadre du Règlement sur l’IA ?

Comment pouvons-nous vous être utiles ? Développement de vos projets, sensibilisation de vos équipes, formation, mise en conformité et gestion de vos risques. Contactez-nous !

Ensemble, développons vos projets et formons vos équipes ! Partageons nos expertises.